用文本了打开日志后,我们发现日志内容是非常乱的,而且没有格式,此时我们需要借助EXCEL或WPS等工具来整理打开

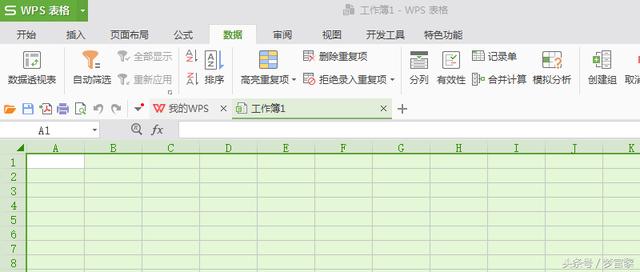

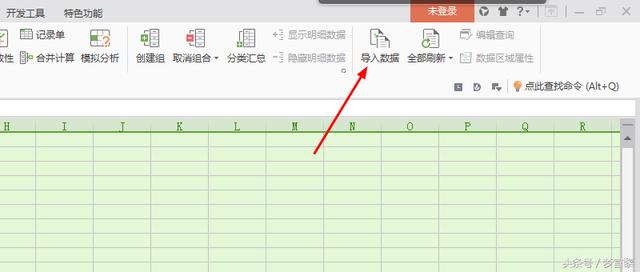

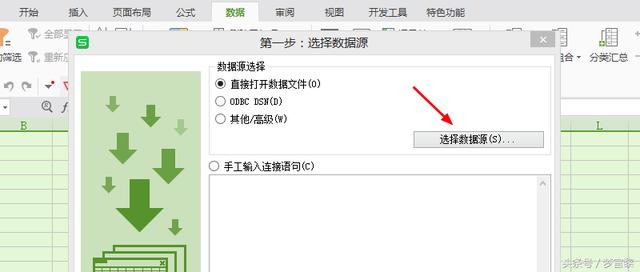

打开WPS,新建一个文件,点击菜单栏“数据”–右方“导入数据”–“选择数据源”–选择“所有文件”找到日志

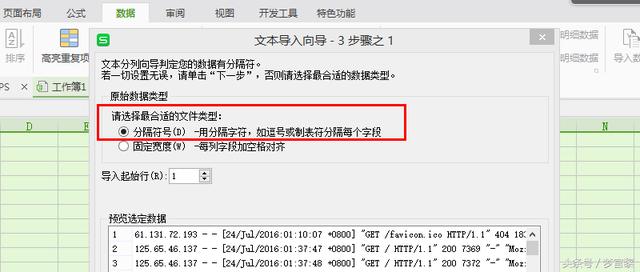

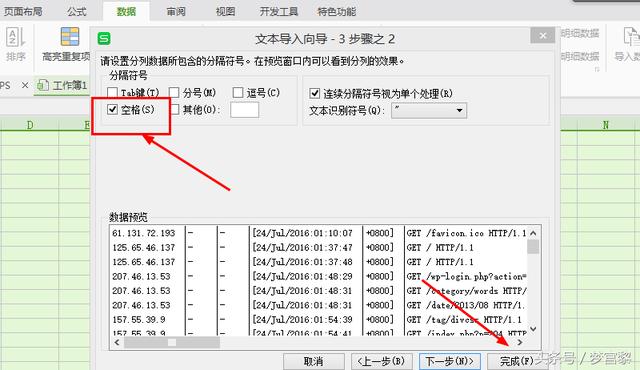

这里选择“分隔符号”

这里选择“空格”,然后点击“完成”及可打开数据。因为表格太大,不方便截图,各位自己下载一个日志打开分析。

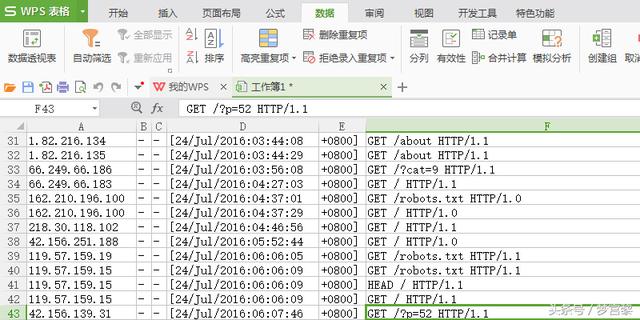

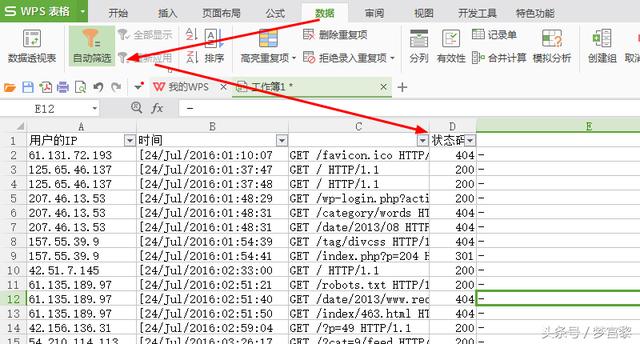

导入数据后,我们会发现有很多单元格是重复的,或者没有数据,此时我们需要将相同的部分删除。剩下的一些单元格需要根据自己的经验进行判断删除

根据经验判断哪个是访客IP,访问时间,哪些是http状态码,熟悉http状态码的含义及筛选出如404状态码对应的有哪些网页,并将这些网页整理提交百度404文件。403是没有权限访问,对网站的优化没有影响,因为搜索引擎抓取到的仅仅是这一层网址,内部的它抓取不到,只要这一层正常就只可以的。只要让403的网址不出现在网站上,就对优化没有影响

304是缓存的意思,告诉你你有缓存,不用再加载了,是正常的

301访问的时候会自动加入一个/,人为的出错,有一定影响。

可以去安装谷歌站长平台,能全部找出哪些页面是异常的,而且会告诉你在哪个位置

可以在用户信息中找到baiduspider百度抓取到了哪些东西?但未必是百度抓的,因为会有人冒充百度蜘蛛。被访问的404页面访问者的ip是一样的,可以证明这个ip是竞争对手想找我们的漏洞,攻击我们,明明我们网站上都没有这些文件。还可以关注时间,没有人一秒钟的时间访问多个页面,遇到404要判断我们的网站是否真有这些页面。

作为SEO,我们所优化的网站,有哪些路径,有哪些CSS自己都要知道,并非所有的你都要去处理。可以看看到别了还扫了我们的zip,数据库等。所以建议不要存放zip文件等在网站根目录。只是竞争对手在探索,找我们的漏洞,只需要加强我们自己的防御就可以了

通过分析网站日志,能及时判断我们网站出了哪些问题并作出相应的优化。站长们一定要注意细节,并且做好网站安全。

还有,我们还要学会判断哪些是真假蜘蛛,分析这些访客是通过什么内核的浏览器访问的。通常最多的还是我们的同行,他们使用的都是谷歌浏览器Chrome内核。